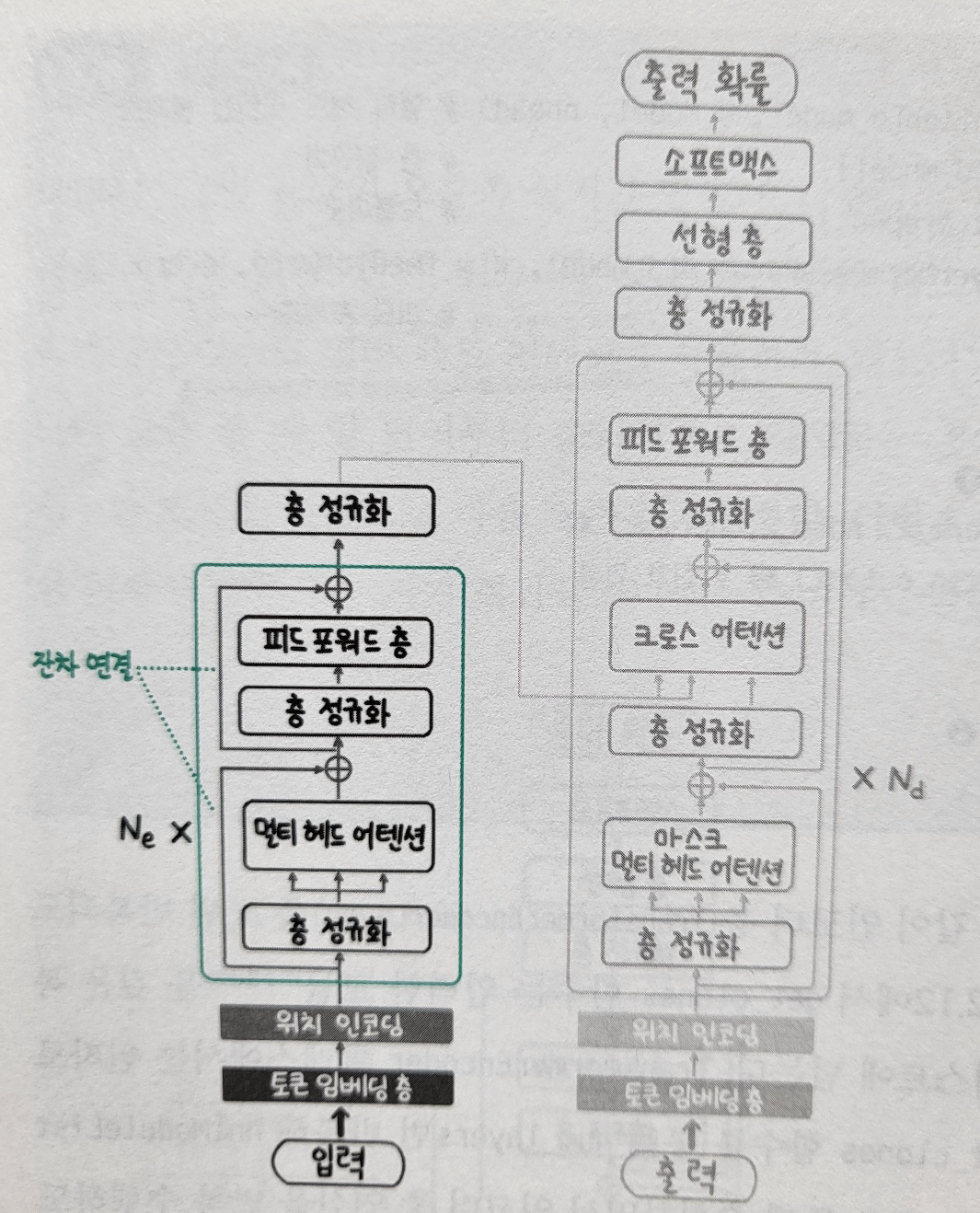

1. 인코더인코더는 입력 텍스트를 이해하고 의미를 추출하는 역할을 합니다. 기본적으로 여러 개의 동일한 층이 반복되는 구조로 되어 있습니다. 1) 인코더의 주요 구성 요소층 정규화(Layer Normalization): 데이터의 분포를 조정하여 학습을 안정화멀티 헤드 어텐션(Multi-Head Attention): 입력 시퀀스의 다양한 관계를 파악피드 포워드 층(Feed Forward Layer): 비선형 변환을 통해 표현력 강화 2) 잔차 연결잔차 연결은 이미지에 보이는 것처럼 원래 입력값을 각 하위 층의 출력에 더해주는 방식을 말합니다. 그래디언트 소실 문제 해결: 깊은 네트워크에서 학습 신호가 손실되는 문제 방지학습 안정화: 층이 많아져도 안정적인 학습 가능정보 보존: 원본 정보가 네트워크를 통과..